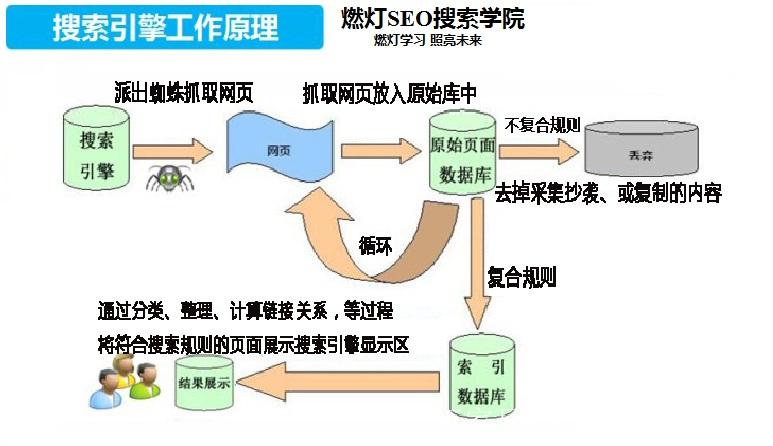

搜索引擎抓取是指搜索引擎通过自动化程序(称为爬虫或蜘蛛)访问和读取互联网上的网页内容,将其提取并存储到搜索引擎的数据库(通常称为索引)。通过抓取,搜索引擎可以索引新内容并定期更新现有内容,从而提供相关的搜索结果。搜索引擎的抓取过程大致可以分为以下几个步骤:

1.URL发现

搜索引擎的爬虫首先通过种子列表(即已知的URL)开始抓取。这些URL可以来自以下来源:

网站地图(Sitemap):网站管理员可以提供一个XML格式的站点地图,帮助搜索引擎发现所有页面。

外部链接(Backlinks):爬虫还会通过跟踪其他网站上的链接来发现新的页面,页面间的超链接构成了网页发现的路径。

内部链接:爬虫会通过网站内部的链接结构发现其他页面。

2.页面抓取

一旦爬虫发现一个新的URL,它将请求该页面并将该页面的HTML内容下载到搜索引擎的服务器上。这个过程包括:

HTTP请求:爬虫向服务器发送一个HTTP请求,获取该网页的内容。

抓取内容:网页内容(HTML、图片、视频、CSS、JavaScript等)会被下载和存储。爬虫还会解析页面中的链接,这些链接将成为爬虫下次抓取的目标。

3.内容解析

当爬虫抓取到一个网页后,它会对该网页的内容进行解析,提取出有用的信息并存入索引数据库。爬虫关注以下几个方面:

文本内容:抓取网页中的标题、段落、列表、表格等文字内容。

元数据:如标题标签(

链接:爬虫会提取页面中的超链接,并将其加入待抓取的URL队列中。这是页面之间互相连接的基础,爬虫通过链接发现更多的页面。

4.遵守规则(robots.txt)

许多网站会使用robots.txt文件来告知爬虫哪些页面可以抓取,哪些页面不可以抓取。爬虫会遵守这些规则,避免抓取不希望被公开的内容。常见的指令包括:

Disallow:指示爬虫不允许抓取的路径。

Allow:指示爬虫允许抓取的路径。

5.存储与索引

爬虫抓取并解析网页内容后,信息会被存储在搜索引擎的索引数据库中。该索引类似于一个巨大的目录,记录了网页上的所有内容及其与其他网页的关系。搜索引擎根据索引中存储的内容来决定如何对用户的搜索查询进行排序。

6.排重(去重)

为了提高索引的质量和搜索结果的相关性,搜索引擎通常会进行排重操作,即消除重复内容。很多时候,不同的网站或网页可能会有相似或相同的内容,爬虫会通过哈希算法或其他技术来判断并去除这些重复数据。

7.更新与重抓取

随着互联网内容的更新和变化,搜索引擎的爬虫会定期重新抓取网站的内容。爬虫会基于页面的更新频率、重要性和外部链接的变化等因素决定抓取频率。一些重要且更新频繁的网站,爬虫可能会每日访问;而一些更新较少的网站,则可能隔几天或几周才抓取一次。

爬虫抓取的挑战与限制

JavaScript和动态内容:现代网站常用JavaScript加载内容,爬虫需要通过额外的处理(如无头浏览器或动态渲染)来抓取这类内容。

反爬虫技术:为了防止爬虫抓取,许多网站使用验证码、IP封锁、JavaScript挑战等手段来阻止自动化程序。

抓取频率限制:为了避免对网站服务器造成过多负担,爬虫通常会设置抓取频率的限制。

总结

搜索引擎的抓取原理是一个复杂的过程,涉及到从发现URL、下载页面内容、解析网页信息、遵循站点规则,到最后存储并索引数据的多个步骤。随着技术的进步,爬虫的抓取能力变得越来越强大,能够处理更复杂的网页结构、动态加载的内容和更加智能的反爬虫机制。然而,随着数据量的激增,爬虫也面临着新的挑战,如处理大规模网站的数据、减少重复内容等。

文章声明:以上内容(如有图片或视频亦包括在内)除非注明,否则均为景儿SEO原创文章,转载或复制请以超链接形式并注明出处。

本文链接:https://www.untib.com/seojc/159.html