相关内容

搜索引擎抓取原理的依据参数

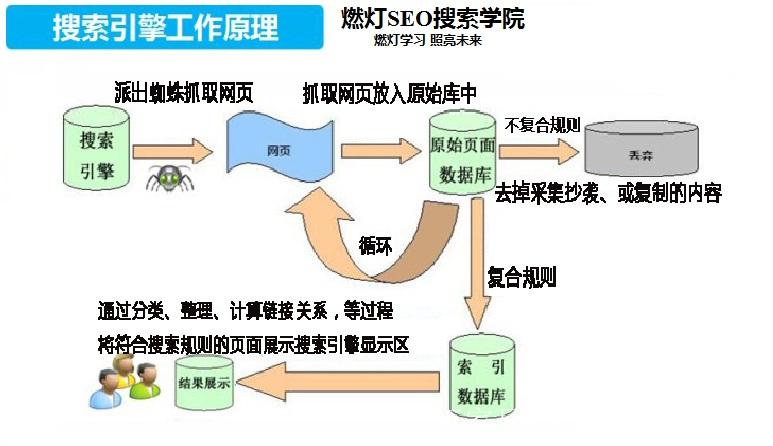

搜索引擎抓取是指搜索引擎通过自动化程序(称为爬虫或蜘蛛)访问和读取互联网上的网页内容,将其提取并存储到搜索引擎的数据库(通常称为索引)。通过抓取,搜索引擎可以索引新内容并定期更新现有内容,从而提供相关的搜索结果。搜索引擎的抓取过程大致可以分为以下几个步骤: 1.URL发现 搜索引擎的爬虫首先通过种子列表(即已知的URL)开始抓取。这些URL可以来自以下来源: 网站地图(Sitemap):